Unser umfassender Leitfaden bietet dir Expertenwissen, das dir hilft, die Performance deiner Website zu optimieren und das Nutzererlebnis zu verbessern.

Was ist A/B-Testing?

A/B-Tests, auch bekannt als Split-Tests, sind eine Marketing-Technik, bei der zwei Versionen einer Webseite oder Anwendung miteinander verglichen werden, um festzustellen, welche besser abschneidet. Diese Varianten, die als A und B bezeichnet werden, werden den Nutzern nach dem Zufallsprinzip präsentiert. Ein Teil von ihnen wird auf die erste Version geleitet, der Rest auf die zweite. Durch eine statistische Analyse der Ergebnisse wird dann ermittelt, welche Version, A oder B, nach bestimmten vordefinierten Indikatoren wie der Conversion Rate besser abschneidet.

Mit anderen Worten: Du kannst überprüfen, welche Version die meisten Klicks, Abonnements, Käufe usw. erhält. Anhand dieser Ergebnisse kannst du dann deine Website für die Conversion Rate optimieren.

A/B-Testing-Beispiele

Du bist auf der Suche nach Ideen für deine nächsten A/B-Tests? Obwohl die Möglichkeiten für A/B-Tests auf deiner Website endlos sind, kann manchmal eine kleine Inspiration durch eine Erfolgsgeschichte sehr hilfreich sein.

Hier sind ein paar Links zu einigen Beispielen von A/B-Tests und deren Ergebnissen:

- 5 A/B-Testing Case Studies und was du von ihnen lernen kannst

- AB Tasty Case Studies Übersicht

- 100 Case Studies zur Conversion-Optimierung

- 50 Case Studies zur Optimierung von A/B-Split-Tests (EN)

Welche Arten von Websites sind für A/B-Tests geeignet?

Jede Website kann von A/B-Tests profitieren, da sie alle eine Daseinsberechtigung haben – und diese ist quantifizierbar. Egal, ob es sich um einen Online Shop, eine Nachrichten-Website oder eine Website zur Lead-Generierung handelt, A/B-Tests können auf verschiedene Weise helfen. Ganz gleich, ob du deinen ROI verbessern, die Absprungrate senken oder die Conversion Rate erhöhen möchtest, A/B-Tests sind eine sehr relevante und wichtige Marketing-Technik.

Lead

Mit „Leads” sind qualifizierte Interessenten, also potenzielle Neukunden gemeint. E-Mail-Marketing ist sehr wichtig, um Leads mit weiteren Inhalten zu versorgen, die Conversion in Gang zu halten, Produkte vorzuschlagen und letztendlich deinen Umsatz zu steigern. Mit A/B-Tests von E-Mails sollte deine Marke beginnen, Trends und gemeinsame Faktoren zu identifizieren, die zu höheren Öffnungs- und Klickraten führen.

Medien

In einem Medienkontext ist es sinnvoller, von „redaktionellen A/B-Tests” zu sprechen. In Branchen, die eng mit der Presse zusammenarbeiten, besteht die Idee hinter A/B-Tests darin, den Erfolg einer bestimmten Inhaltskategorie zu testen. Zum Beispiel, wenn man herausfinden will, ob sie perfekt zur Zielgruppe passt. Im Gegensatz zum obigen Beispiel hat das A/B-Testing hier eine redaktionelle und keine vertriebliche Funktion. A/B-Tests von Headlines sind in der Medienbranche eine gängige Praxis.

E-Commerce

Es überrascht nicht, dass der Einsatz von A/B-Tests im Zusammenhang mit dem E-Commerce darauf abzielt, zu messen, wie gut eine Website oder eine kommerzielle Online App ihre Waren verkauft. Bei A/B-Tests wird anhand der Anzahl der abgeschlossenen Verkäufe ermittelt, welche Version am besten abschneidet. Es ist besonders wichtig, die Startseite und das Design der Produktseiten zu betrachten, aber es ist auch eine gute Idee, alle visuellen Elemente zu berücksichtigen, die beim Kaufabschluss eine Rolle spielen (Buttons, Call-to-Action).

Welche A/B-Tests solltest du verwenden?

Klassischer A/B-Test: Beim klassischen A/B-Test werden den Nutzern zwei Varianten deiner Seiten unter derselben URL präsentiert. Auf diese Weise kannst du zwei oder mehrere Varianten desselben Elements miteinander vergleichen.

Split-Tests oder Redirect-Tests: Beim Split-Test wird dein Traffic auf eine oder mehrere unterschiedliche URLs umgeleitet. Das kann besonders interessant sein, wenn du neue Seiten auf deinem Server hostest.

Multivariate oder MVT-Tests: Beim multivariaten Test werden die Auswirkungen mehrerer Änderungen auf ein und derselben Webseite gemessen. Du kannst zum Beispiel dein Banner, die Farbe deines Textes, deine Präsentation und vieles mehr ändern.

A/B-Testing ist möglich:

Auf Websites

Mit dem A/B- Test für Webseiten kann eine Version A einer Website mit einer Version B verglichen werden. Die Ergebnisse werden hinterher nach vorher festgelegten Zielen analysiert: Klicks, Einkäufe, Abonnements etc.

In nativen mobilen Apps

A/B-Tests in Apps sind komplex, weil es nicht möglich ist, nach dem Download zwei verschiedene Versionen anzuzeigen. Schnelle Aktualisierungen ermöglichen jedoch einfache Design-Änderungen und direkte Wirkungsanalysen.

Über serverbasierte APIs

Eine API ist eine Programmierschnittstelle, die eine Verbindung mit einer Software zum Austausch der Daten ermöglicht. Mit APIs kannst du anhand gespeicherter Daten automatisch Kampagnen oder Varianten erstellen.

A/B-Testing und Conversion Optimization

Conversion-Optimierung und A/B-Tests sind zwei Möglichkeiten für Unternehmen, ihre Gewinne zu steigern. Ihr Versprechen ist einfach: mehr Umsatz bei gleichem Traffic. Warum solltest du angesichts hoher Akquisitionskosten und komplexer Traffic-Quellen nicht damit beginnen, das Beste aus deinem derzeitigen Traffic herauszuholen?

Überraschenderweise liegen die durchschnittlichen Conversion Rates für E-Commerce-Websites nach wie vor zwischen 1 % und 3 %. Und warum? Weil die Conversion ein komplexer Mechanismus ist, der von einer Reihe von Faktoren abhängt. Dazu gehören Dinge wie die Qualität des generierten Traffics, die Benutzererfahrung, die Qualität des Angebots, der Ruf der Website sowie die Aktivitäten der Konkurrenz. E-Commerce-Profis sind natürlich bestrebt, die negativen Auswirkungen, die das Zusammenspiel der oben genannten Faktoren auf die Verbraucher während der Customer Journey haben könnte, zu minimieren.

Es gibt eine Reihe von Methoden, die dir dabei helfen, dies zu erreichen, darunter A/B-Tests, eine Disziplin, die Daten nutzt, um dir zu helfen, die besten Entscheidungen zu treffen. A/B-Tests sind nützlich, um eine umfassendere Strategie zur Optimierung der Conversion Rate zu entwickeln, reichen aber allein keineswegs aus. Mit einer A/B-Testing-Lösung kannst du bestimmte Hypothesen statistisch überprüfen, aber sie allein kann dir kein differenziertes Verständnis des Nutzerverhaltens vermitteln.

Allerdings ist das Verständnis des Nutzerverhaltens sicherlich der Schlüssel zum Verständnis von Problemen bei der Conversion. Deshalb ist es wichtig, A/B-Tests mit Informationen aus anderen Quellen anzureichern. Auf diese Weise erhältst du ein umfassenderes Bild von deinen Nutzern und kannst vor allem Hypothesen aufstellen, die du testen kannst. Es gibt viele Informationsquellen, die du nutzen kannst, um ein umfassenderes Bild zu erhalten:

- Web Analytics Daten. Diese Daten erklären zwar nicht das Nutzerverhalten, können aber Probleme bei der Conversion aufzeigen (z. B. bei der Identifizierung von Warenkorbabbrüchen). Sie können dir auch bei der Entscheidung helfen, welche Seiten zuerst getestet werden sollen.

- Ergonomische Prüfung. Diese Analysen geben – zu geringen Kosten – Aufschluss über die Erfahrung mit der Webseite aus der Sicht des Nutzers.

- User-Tests. Auch wenn die Stichprobengröße begrenzt ist, können User-Tests eine Vielzahl von Informationen liefern, die mit quantitativen Methoden nicht zugänglich sind.

- Heatmap und Session Recording. Diese Methoden machen sichtbar, wie Nutzer mit den Elementen auf einer Seite oder zwischen mehreren Seiten interagieren.

- Kunden-Feedback. Unternehmen sammeln große Mengen an Feedback von ihren Kunden (z. B. auf der Website aufgeführte Meinungen, Fragen an den Kundendienst). Neben der Feedback-Analyse können auch Kundenbefragungen, Live-Chats etc. genutzt werden.

Wie findet man Ideen für A/B-Tests?

Um einen A/B-Test durchzuführen, benötigst du zunächst zusätzliche Informationen, mit denen du deine Conversion-Probleme identifizieren und das Nutzerverhalten verstehen kannst. Diese Phase ist besonders wichtig und muss mit der Formulierung „starker” Hypothesen enden. Die oben genannten Disziplinen helfen dir bei dieser Aufgabe. Eine korrekt formulierte Hypothese ist der erste Schritt zu einem erfolgreichen A/B-Testing und muss die folgenden Regeln beachten. Hypothesen müssen:

- sich auf ein klar umrissenes Problem beziehen, dessen Ursachen identifizierbar sind

- eine mögliche Lösung für das Problem erwähnen

- das erwartete Ergebnis angeben, das direkt mit dem zu messenden KPI verknüpft ist

Wenn das Problem beispielsweise in einer hohen Abbruchrate bei einem Registrierungsformular besteht, das zu lang zu sein scheint, könnte eine Hypothese so lauten: „Das Kürzen des Formulars, wobei optionale Felder entfernt werden, steigert die Zahl der registrierten Kontakte.”

Was solltest du auf deiner Website mit A/B-Tests testen?

Was solltest du auf deiner Website testen? Diese Frage taucht immer wieder auf, weil Unternehmen oft nicht wissen, wie sie ihre Conversion Rate – ob gut oder schlecht – erklären sollen. Wenn ein Unternehmen sicher sein könnte, dass seine Nutzer Schwierigkeiten haben, ihr Produkt zu verstehen, würde es sich nicht die Mühe machen, die Position oder die Farbe eines „In den Warenkorb“-Buttons zu testen – das wäre nicht zum Thema passend.

Stattdessen würden sie verschiedene Formulierungen ihrer Kundenvorteile testen. Jede Situation ist anders. Anstatt eine vollständige Liste der zu testenden Elemente zu erstellen, geben wir lieber einen A/B-Test-Rahmen zur Identifizierung dieser Elemente an die Hand.

Im Folgenden findest du einige gute Anhaltspunkte für den Anfang:

- Titel und Überschriften

Beginne z. B. mit der Änderung von Überschriften oder Inhalten deiner Artikel, um zu prüfen, was die Nutzer mehr anspricht. Was die Form betrifft, könnte eine Änderung der Farbe oder Schriftart einen Unterschied machen.

- Call-to-Action

Der CTA-Button ist sehr wichtig. Die Farbe, die Schrift, die Platzierung und die verwendeten Wörter („kaufen“, „zum Warenkorb hinzufügen“, „bestellen“…) können sich entscheidend auf deine Conversion Rate auswirken.

- Formulare

Deine Formulare müssen klar und deutlich sein. Teste, wie sich eine Änderung des Wortlauts der Felder, das Entfernen von optionalen Feldern, eine andere Platzierung der Felder oder eine Anordnung in Zeilen oder Spalten etc. auswirkt.

- Navigation

Du kannst verschiedene Seitenfolgen testen und mehrere Conversion Funnel anbieten, die aus einem oder mehreren Teilen bestehen. So kannst du zum Beispiel für die Zahlungsart und die Lieferangaben eine einzige oder zwei Seiten nutzen.

- Landing Pages

Landing Pages zur Lead-Generierung sind entscheidend, um den Benutzer zum Handeln zu bewegen. Split-Tests vergleichen verschiedene Seitenversionen und bewerten unterschiedliche Layouts oder Designs.

- Bilder

Bilder sind genauso wichtig wie Texte. Daher ist es ratsam, verschiedene Bilder auszuprobieren. Variiere bei der Größe und Ästhetik deiner Fotos und bei der Platzierung, um zu testen, was am besten bei deiner Zielgruppe ankommt.

- Seitenstruktur

Die Struktur deiner Seiten muss gut durchdacht sein – ob es sich nun um deine Startseite oder deine verschiedenen Kategorien handelt. Du kannst ein Karussell hinzufügen, feste Bilder auswählen, deine Banner ändern, beliebte Produkte auf der Startseite anzeigen usw.

- Algorithmen

Nutze verschiedene Algorithmen, um deine Besucher zu Käufern zu machen oder ihren Warenkorbwert zu steigern: ähnliche Artikel, am meisten gesuchte Produkte… So kannst du deinen potenziellen Kunden Artikel vorschlagen, die sie wahrscheinlich interessieren.

- Preise

Schwieriger ist es, einen A/B-Test mit Preisen durchzuführen. Das liegt daran, dass du das gleiche Produkt oder den gleichen Service ja nicht zu verschiedenen Preisen verkaufen kannst. Um die Auswirkung auf deine Conversion Rate zu testen, brauchst du daher ein wenig Einfallsreichtum.

- Geschäftsmodell

Überdenke deinen Aktionsplan, um höhere Gewinne zu erzielen. Wenn du zum Beispiel ganz spezielle Ware verkaufst, denk auch daran, weitere passende Produkte oder ergänzende Dienstleistungen mit ins Angebot aufzunehmen.

Wenn du konkretere Ideen auf der Grundlage der individuellen Customer Journey deiner Nutzer auf deiner Website suchst, solltest du dir unser E-Book zur digitalen Customer Journey und unser Use Case Booklet ansehen, die dich mit Erfolgsgeschichten rund um das Thema A/B-Testing inspirieren.

Tipps und Best Practices für A/B-Testing

Hier sind einige Tipps, die dir Ärger und Unannehmlichkeiten ersparen können. Sie beruhen auf den sowohl guten als auch schlechten Erfahrungen, die unsere Kunden beim Testing gemacht haben.

Stell die Zuverlässigkeit der Daten für die Testing-Lösung sicher

Führe mindestens einen A/A-Test durch, um sicherzustellen, dass deine Besucher nach dem Zufallsprinzip auf die verschiedenen Versionen verteilt werden. Dies ist auch eine gute Gelegenheit, die Indikatoren des A/B-Test-Tools mit denen deines Web Analytics Tools zu vergleichen. Achte hier auf die Größenordnungen und kümmere dich nicht so sehr um die exakte Entsprechung der Zahlen.

Führe vor dem Start einen Prüftest durch

Einige Ergebnisse scheinen kontraintuitiv? Sind die Einstellungen des Tests alle richtig und wurden die Ziele korrekt definiert? Die Zeit, die du für die Überprüfung des Tests aufwendest, erspart dir im besten Fall die Zeit, die du sonst mit der Deutung falscher Ergebnisse verbracht hättest.

Teste nur eine Variable

Auf diese Weise kann die Wirkung dieser einzelnen Variable analysiert werden. Wenn z. B. die Platzierung eines Call-to-Action-Buttons und der im Button stehende Text gleichzeitig verändert werden, kannst du unmöglich feststellen, welche der beiden Änderungen zu dem Ergebnis geführt hat.

Führe nur einen Test auf einmal durch

Aus demselben Grund sollte nur ein Test auf einmal durchgeführt werden. Zwei gleichzeitig laufende Tests machen es schwierig, die Ergebnisse auszuwerten, besonders, wenn sie dieselbe Seite betreffen.

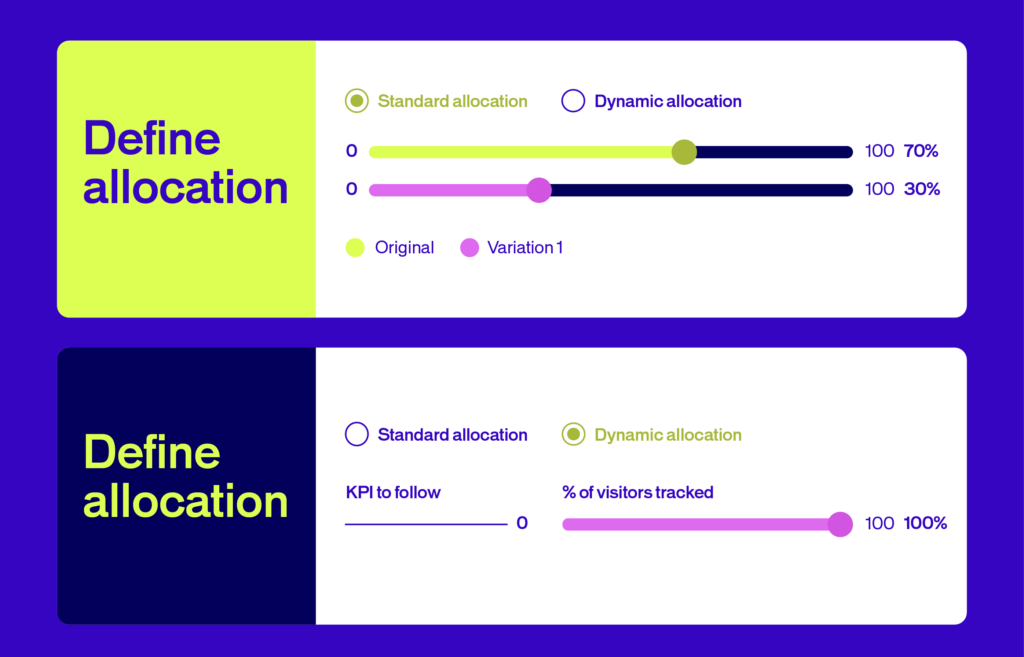

Pass die Zahl der Varianten an das Traffic-Volumen an

Wenn es viele Varianten und wenig Traffic gibt, wird der Test sehr lange dauern, bevor stichhaltige Ergebnisse vorliegen. Je weniger Traffic den Testversionen zugewiesen wird, desto weniger Versionen sollte es geben.

Warte ab, bis du statistische Zuverlässigkeit hast, bevor du handelst

Solange der Test nicht eine statistische Zuverlässigkeitsrate von mindestens 95 % erreicht hat, sollten keine Entscheidungen getroffen werden. Bei einer niedrigeren Rate ist die Wahrscheinlichkeit, dass die festgestellten Unterschiede auf dem Zufall und nicht auf den getätigten Änderungen beruhen, zu groß.

Lass einen Test lange genug laufen

Auch wenn die Zuverlässigkeitsrate schnell erreicht ist, sollten der Stichprobenumfang und die Unterschiede beim Nutzerverhalten in Bezug auf die Wochentage berücksichtigt werden. Ein Test sollte mindestens eine Woche dauern, im Idealfall zwei. Außerdem sollten mindestens 5.000 Besucher und 75 Conversions pro Version registriert werden.

Braucht der Test zu lange, beende ihn

Wenn es bei einem Test zu lange dauert, bis eine Zuverlässigkeitsrate von 95 % erreicht wird, ist es wahrscheinlich, dass das getestete Element keine Auswirkungen auf den gemessenen Indikator hat. In diesem Fall nützt es nichts, den Test fortzusetzen. Nutze den Traffic lieber für einen anderen Test.

Miss mehrere Indikatoren

Es ist ratsam, während des Tests mehrere Ziele zu messen: ein primäres Ziel, mit dem die Varianten bestimmt werden, und sekundäre Ziele für eine tiefergehende Analyse der Ergebnisse. Es können folgende Indikatoren gemessen werden: die Klickrate, die Rate zum Hinzufügen zum Warenkorb, die Conversion Rate, der durchschnittliche Warenkorbwert etc.

Berücksichtige Werbeaktionen während eines Tests

Externe Variablen können die Ergebnisse eines Tests verfälschen. Oft sind es Kampagnen zur Traffic-Generierung, die Besucher mit unüblichem Verhalten anziehen. Es ist besser, solche Nebeneffekte zu vermeiden, indem man Tests oder Werbekampagnen verschiebt.

Segmentiere die Zielgruppe des Tests

In manchen Fällen ergibt es wenig Sinn, einen Test mit allen Besuchern einer Seite durchzuführen. Wenn z. B. getestet werden soll, wie sich unterschiedliche Formulierungen von Kundenvorteilen auf die Registrierungsrate einer Seite auswirken, ist es unnötig, die bereits registrierten Nutzer zu testen. Der Test sollte stattdessen auf neue Besucher abzielen.

Auswahl einer A/B-Testing-Software

Die Wahl des besten A/B-Test-Tools ist schwierig.

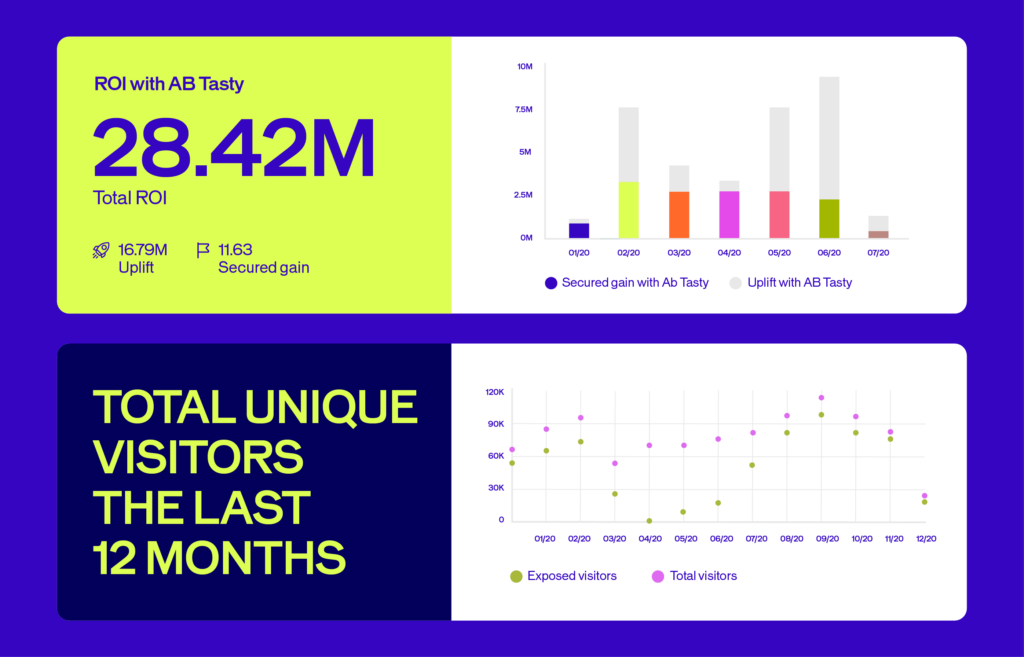

Wir können dir nur empfehlen, AB Tasty zu verwenden. AB Tasty bietet nicht nur eine vollständige A/B-Testing-Lösung, sondern auch eine Reihe von Software zur Optimierung deiner Conversions. Außerdem kannst du deine Website anhand zahlreicher Targeting-Kriterien und Zielgruppensegmentierungen personalisieren.

Um jedoch möglichst umfassend zu sein und dir bei der Auswahl eines Anbieters so viele wertvolle Informationen wie möglich zu liefern, findest du hier einige Artikel, die dir bei der Auswahl deines A/B-Testing-Tools anhand von Software-Bewertungen helfen sollen:

- A/B-Testing: Das sind die wichtigsten Tools für die Website-Optimierung

- 29 A/B-Testing- & Personalisierungs-Tools im Vergleich

- Welches A/B-Testing-Tool solltest du für Split-Testing nutzen? (EN)

- Die 18 besten A/B-Testing-Tools laut CRO-Experten (EN)

Verstehen von A/B-Testing-Statistiken

Die Phase der Testanalyse ist die heikelste. Die A/B-Testing-Lösung muss zumindest eine Report-Schnittstelle bieten, welche die nach Variationen gespeicherten Conversions, die Conversion Rate, die prozentuale Verbesserung im Vergleich zum Original und den für jede Variation gespeicherten statistischen Zuverlässigkeitsindex anzeigt. Die fortschrittlichsten Lösungen grenzen die Rohdaten ein und segmentieren die Ergebnisse nach Dimensionen (z. B. Traffic-Quelle, geografischer Standort der Besucher, Kundentypologie usw.).

Bevor die Testergebnisse analysiert werden können, besteht die größte Schwierigkeit darin, ein ausreichendes statistisches Signifikanzniveau zu erreichen. Im Allgemeinen wird ein Schwellenwert von 95 % angenommen. Das bedeutet, dass die Wahrscheinlichkeit, dass die Ergebnisunterschiede zwischen den Varianten auf Zufall beruhen, sehr gering ist. Die Zeit, die zum Erreichen dieses Schwellenwerts erforderlich ist, variiert erheblich, je nach dem Besucheraufkommen der getesteten Seiten, der anfänglichen Conversion Rate für das gemessene Ziel und den Auswirkungen der vorgenommenen Änderungen. Sie kann von einigen Tagen bis zu mehreren Wochen reichen. Für Websites mit geringem Traffic ist es ratsam, eine Seite mit höherem Traffic zu testen. Bevor der Schwellenwert erreicht ist, ist es sinnlos, irgendwelche Schlussfolgerungen zu ziehen.

Außerdem basieren die statistischen Tests, die zur Berechnung des Konfidenzniveaus verwendet werden (z. B. der Chi-Quadrat-Test), auf einem Stichprobenumfang nahe der Unendlichkeit. Sollte der Stichprobenumfang gering sein, ist bei der Analyse der Ergebnisse Vorsicht geboten, selbst wenn der Test eine Zuverlässigkeit von mehr als 95 % anzeigt.

Bei einem geringen Stichprobenumfang ist es möglich, dass sich die Ergebnisse stark verändern, wenn man den Test noch einige Tage lang aktiv lässt. Aus diesem Grund ist es ratsam, eine ausreichend große Stichprobe zu haben. Es gibt wissenschaftliche Methoden, um die Größe dieser Stichprobe zu berechnen, aber aus praktischer Sicht ist es ratsam, eine Stichprobe von mindestens 5.000 Besuchern und 75 gespeicherten Conversions pro Variante zu haben.

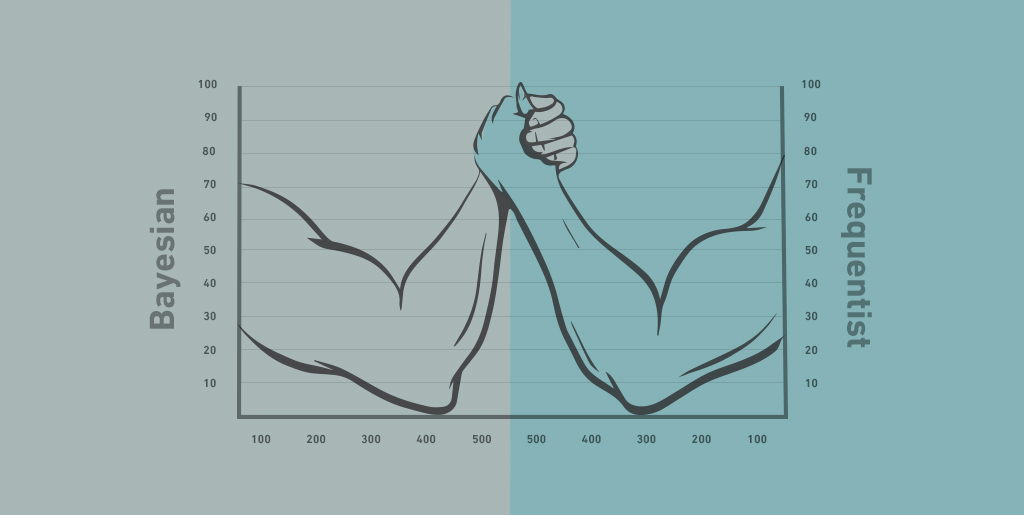

Es gibt zwei Arten von statistischen Tests:

- Frequentistische Tests. Die Chi-Quadrat-Methode oder Frequentist-Methode ist objektiv. Sie erlaubt eine Analyse der Ergebnisse erst am Ende des Tests. Die Studie basiert also auf Beobachtungen und hat eine Zuverlässigkeit von 95 %.

- Bayes’sche Tests. Die Bayes’sche Methode ist deduktiv. Sie geht von den Gesetzen der Wahrscheinlichkeit aus und ermöglicht eine Analyse der Ergebnisse vor dem Ende des Tests. Achte jedoch darauf, dass du das Konfidenzintervall richtig liest. In unserem speziellen Artikel erfährst du alles über die Vorteile der Bayes’schen Statistik für A/B-Tests.

Auch wenn die Besucherzahlen auf der Website es ermöglichen, schnell eine ausreichend große Stichprobe zu erhalten, wird empfohlen, den Test über mehrere Tage laufen zu lassen, um die Unterschiede im Verhalten an den einzelnen Wochentagen oder sogar zu bestimmten Tageszeiten zu berücksichtigen. Eine Mindestdauer von einer Woche ist empfehlenswert, idealerweise zwei Wochen. In einigen Fällen kann dieser Zeitraum sogar länger sein, insbesondere wenn die Umstellung Produkte betrifft, deren Kaufzyklus Zeit erfordert (komplexe Produkte/Dienstleistungen oder B2B). Es gibt also keine Standarddauer für einen Test.

Andere Formen von A/B-Tests

A/B-Tests beschränken sich nicht auf Änderungen an den Seiten deiner Website. Du kannst das Konzept auf alle deine Marketingaktivitäten anwenden, z. B. auf die Traffic-Akquise über E-Mail-Marketing-Kampagnen, AdWords-Kampagnen, Facebook-Anzeigen und vieles mehr.

Ressourcen für weiterführende A/B-Tests:

- Ein Leitfaden zum A/B-Testing im E-Mail-Marketing

- 7 Tips for Implementing A/B Testing in Your Social Media Campaigns (EN)

- Social Media A/B-Testing mit den Tools, die Sie bereits einsetzen

- Google Adwords: Mehr Performance mit A/B-Tests (EN)

Die besten Ressourcen für A/B-Tests und CRO

Wir empfehlen dir, in unserem eigenen Blog über A/B-Tests zu stöbern, aber auch andere Experten für internationale Optimierung veröffentlichen sehr relevante Artikel zum Thema A/B-Tests und Conversion im Allgemeinen. Hier ist unsere Auswahl, um in der Welt der CRO auf dem Laufenden zu bleiben.

Blogs zum Vormerken: